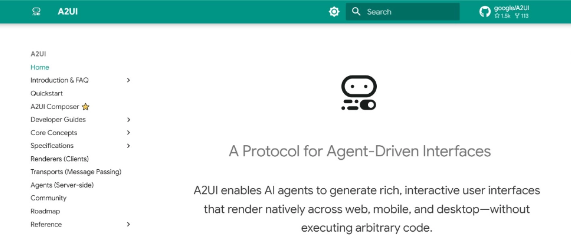

A2UI – 谷歌开源Agent生成用户界面的声明式协议,支持定制化

a2ui(agent-to-user interface)是谷歌推出的开源协议,专为ai agent与用户界面之间的高效、安全交互而设计。核心是让AI生成“界面描述数据”,而非可执行代码,客户端通过预...

Step-GUI – 阶跃星辰推出的AI Agent系列模型,10分钟就能在手机端部署

step-gui 是阶跃星辰推出的ai agent系列模型,包含云侧模型 step-gui 和端侧模型 step-gui edge(原名:gelab-zero)。用户只需10分钟就能在手机端部署AI助...

Seedance 1.5 Pro – 字节推出的音画同步多模态视频模型,整体效果自然流畅。

字节跳动推出的Seedance 1.5 Pro模型,具备原生音画同步能力的多模态视频生成模型。该模型可实现精准音画同步,实现较高的视听一致性,且支持多种语言和地方方言口音,能够捕捉其独有的语音韵律与情...

万相2.6 – 阿里通义推出的新一代视频生成系列模型,首个支持角色扮演模型

阿里通义推出万相2.6系列模型,支持音画同步、多镜头生成及声音驱动等功能。旨在实现生成视频在画面与声音上的整体一致性。其分镜控制功能可依据语义理解,将原始素材构建为包含多镜头切换的专业叙事段落。该版本...

Molmo 2 – Ai2开源的AI视频分析模型,提供灵活的多模态处理能力

艾伦人工智能研究所(Ai2)发布了全新的 Molmo2开源视频语言模型,支持多图像.视频输入,能推理事件、生成字幕并追踪物体。模型基于 Qwen 3 和 Olmo 架构,具备强大的视频分析能力,能在视...

MiMo-V2-Flash – 小米开源的高性能语言模型,生成速度提升2倍

mimo-v2-flash 是小米推出的开源高性能大语言模型,整体参数量达3090亿,其中每轮推理激活参数为150亿。仅用了309B的参数规模,该模型就展现出了极高的效能密度,在多项权威综合评测中均取...

LongCat-Video-Avatar – 美团开源的数字人视频生成模型,支持音频文本生成视频

LongCat-Video-Avatar 是由美团开源的一个基于深度学习的视频生成模型,旨在生成高质量的数字人视频。支持音频、文本或图像输入生成拟真视频,通过创新技术提升动作自然度、长视频稳定性及角色...

GPT Image 1.5 – OpenAI最新推出的图像生成模型,指令精准修改图像

GPT-image-1.5 是 OpenAI 的最新前沿图像生成模型。 它改进了性能、质量、编辑控制和面部保存。能够更好地遵循指令、以特定方式编辑照片,并且生成结果的速度比之前的图像生成模型提升了四倍...

Wan-Move – 阿里联合清华等开源的运动可控视频生成框架

wan-move 是由阿里巴巴通义实验室等单位联合推出的开源运动可控视频生成框架,依托潜在空间中的轨迹引导机制,实现高精度、高保真的视频运动调控。该框架能够生成长达5秒、分辨率为480p的视频,并且其...

Disco – Google Labs推出的实验性AI浏览器,用户能实时操作和调整内容

谷歌推出实验性AI浏览器Disco,该浏览器利用Gemini技术,其GenTabs功能可将多个标签页转化为定制化的Web应用,旨在提升浏览器的生产力工具功能。GenTabs 能生成包含交互地图和行程构...