近日,通义实验室自然语言智能团队正式发布并开源了VRAG-RL——一款视觉感知驱动的多模态RAG推理框架,专注于提升视觉语言模型(VLMs)在处理视觉丰富信息时的检索、推理和理解能力。基于定义视觉感知动作空间,让模型能从粗粒度到细粒度逐步获取信息,更有效地激活模型的推理能力。旨在解决在真实业务场景中,AI如何从图像、表格、设计稿等视觉语言中检索关键信息并进行精细化推理的难题。

在复杂视觉文档知识库中检索并推理关键信息,一直是AI领域的一大挑战。传统的检索增强型生成(RAG)方法在处理视觉丰富信息时显得力不从心,主要因为它们难以应对图像、图表等视觉内容,且现有视觉RAG方法受限于固定的检索-生成流程,难以充分挖掘视觉信息中的关键知识。

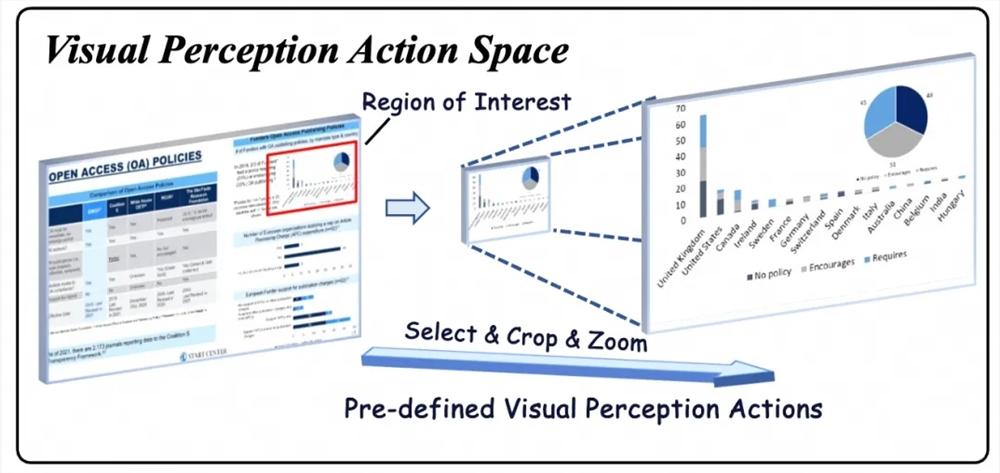

为应对这些挑战,VRAG-RL框架从强化学习赋能多模态智能体训练、视觉感知机制设计以及检索与推理协同优化三个维度进行了系统性创新。它引入了多样化的视觉感知动作,如区域选择、裁剪、缩放等,使模型能够从粗粒度到细粒度逐步聚焦信息密集区域,精准提取关键视觉信息。这种从粗到细的感知方式,不仅提高了模型对视觉信息的理解能力,还显著提升了检索效率。

VRAG-RL还引入了业界领先的GRPO算法,通过本地部署搜索引擎模拟真实世界应用场景,实现搜索引擎调用零成本,模型训练更加高效。这种训练方式不仅提升了模型的泛化能力,还使其在不同领域、不同类型的视觉任务中都能表现出色。

此外,VRAG-RL支持多轮交互,能够在推理阶段逐步聚焦于信息密集区域,实现从粗到细的信息获取。同时,该方法通过优化检索效率和推理路径,在保持高效率的同时,显著提升了模型在视觉任务上的性能。

VRAG-RL的主要功能

- 视觉感知增强:基于定义视觉感知动作空间(如裁剪、缩放),让模型能从粗粒度到细粒度逐步获取信息,更有效地激活模型的推理能力。

- 多轮交互推理:支持多轮交互,让模型能与搜索引擎进行持续交互,逐步优化推理过程。

- 综合奖励机制:结合检索效率和基于模型的结果奖励,全面指导模型优化推理和检索能力,让模型更贴近实际应用场景。

- 可扩展性:框架具有良好的可扩展性,支持多种工具和模型的集成,方便用户自定义和扩展。

VRAG-RL的技术原理

- 视觉感知动作空间:定义一组视觉感知动作,包括选择感兴趣区域、裁剪和缩放。动作让模型逐步从粗粒度到细粒度获取信息,更有效地关注信息密集区域。

- 强化学习框架:用强化学习(RL)优化模型的推理和检索能力。基于与搜索引擎的交互,模型自主采样单轮或多轮推理轨迹,基于样本进行持续优化。

- 综合奖励机制:设计一种综合奖励函数,包括检索效率奖励、模式一致性奖励和基于模型的结果奖励。奖励机制关注最终结果,优化检索过程,让模型更有效地获取相关信息。

- 多轮交互训练:基于多轮交互训练策略,模型在与外部环境的持续交互中逐步优化推理过程,提升推理的稳定性和一致性。

- 数据扩展和预训练:基于多专家采样策略扩展训练数据,确保模型在预训练阶段学习到有效的视觉感知和推理能力。

VRAG-RL的项目地址

- GitHub仓库:https://github.com/Alibaba-NLP/VRAG

- HuggingFace模型库:https://huggingface.co/collections/autumncc/vrag-rl

VRAG-RL的应用场景

- 智能文档问答:快速从PPT、报告等文档中检索和理解信息,高效回答问题。

- 视觉信息检索:从大量图表、图片中快速定位并提取相关视觉信息。

- 多模态内容生成:结合视觉和文本信息,生成图文并茂的总结、报告等。

- 教育与培训:辅助教学,帮助学生更好地理解和分析视觉材料。

- 智能客服与虚拟助手:处理用户提出的涉及视觉内容的问题,提供准确回答。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...