近日,阿里语音AI团队宣布开源全球首个支持链式推理的音频生成模型ThinkSound,该模型首次将CoT(Chain-of-Thought,思维链)技术引入音频生成领域,实现通过多步骤推理模拟专业音效师工作流程,精准捕捉视觉细节并生成与画面同步的高保真音频。这一突破标志着AI音频技术从“看图配音”向“结构化理解画面”的跨越式发展。目前,ThinkSound的代码和预训练模型已同步在GitHub、HuggingFace及阿里魔搭社区开源,开发者可免费下载体验。

ThinkSound是什么

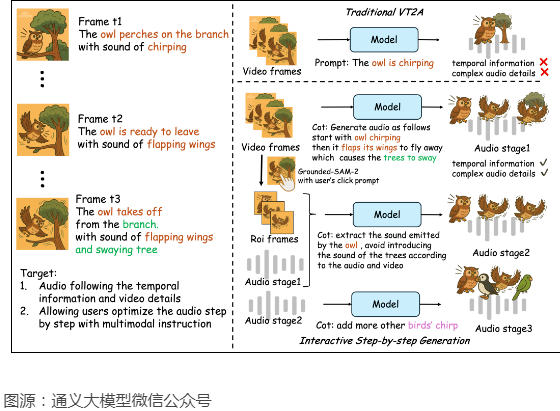

ThinkSound是阿里通义语音团队推出的首个CoT(链式思考)音频生成模型,用在视频配音,为每一帧画面生成专属匹配音效。模型引入CoT推理,解决传统技术难以捕捉画面动态细节和空间关系的问题,让AI像专业音效师一样逐步思考,生成音画同步的高保真音频。模型基于三阶思维链驱动音频生成,包括基础音效推理、对象级交互和指令编辑。模型配备AudioCoT数据集,包含带思维链标注的音频数据。在VGGSound数据集上,ThinkSound超越6种主流方法(Seeing&Hearing、V-AURA、FoleyCrafter、Frieren、V2A-Mapper和MMAudio),展现出卓越的性能。

ThinkSound的主要功能

基础音效生成:根据视频内容生成与之语义和时间上匹配的基础音效,为视频提供初步的音频背景。

交互式对象级细化:支持用户点击视频中的特定对象,对特定对象的音效进行细化和优化,让音效更加精准地贴合特定视觉元素。

指令驱动的音频编辑:支持用户基于自然语言指令对生成的音频进行编辑,如添加、删除或修改特定音效,满足不同的创作需求。

ThinkSound的技术原理

链式思考推理:将音频生成任务分解为多个推理步骤,包括分析视觉动态、推断声学属性和按时间顺序合成音效,模仿人类音效师的创作流程。

多模态大语言模型(MLLM):基于VideoLLaMA2等模型提取视频的时空信息和语义内容,生成结构化的CoT推理链,为音频生成提供详细的指导。

统一音频基础模型:基于条件流匹配技术,结合视频、文本和音频上下文信息,生成高保真音频。模型支持任意输入模态组合,灵活处理不同的生成和编辑任务。

数据集支持:基于AudioCoT数据集,提供带结构化CoT标注的音频数据,用在训练和优化模型,提升对音画关系的理解和生成能力。

ThinkSound的应用场景

影视制作:为电影、电视剧和短视频生成逼真的背景音效和特定场景的音效,提升观众的沉浸感,增强音画同步的真实感。

游戏开发:为游戏场景生成动态的环境音效和交互式音效,增强玩家的沉浸感和互动性,提升游戏体验。

广告和营销:为广告视频和社交媒体内容生成吸引人的音效和背景音乐,增强内容的吸引力和传播力,提升品牌影响力。

教育和培训:为在线教育视频和模拟训练环境生成与内容匹配的音效,帮助学生更好地理解和记忆,提升学习效果和培训质量。

虚拟现实(VR)和增强现实(AR):在VR和AR应用中生成与虚拟环境高度匹配的音效,提升用户的沉浸感和互动性,提供更加个性化的体验。

本站信息分享,不代表本站观点和立场,如有侵权请联系作者立删。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...