小米正式发布并开源声音理解大模型MiDashengLM-7B,MiDashengLM-7B采用小米自研的Xiaomi Dasheng作为音频编码器,并结合Qwen2.5-Omni-7B Thinker作为自回归解码器,通过通用音频描述训练策略,对各类声音信号形成了深度语义理解能力。相比同类产品,其响应延迟大幅缩短,并支持更大规模的并发处理,能够满足智能家居、汽车座舱和移动设备等多场景下的实时交互需求。

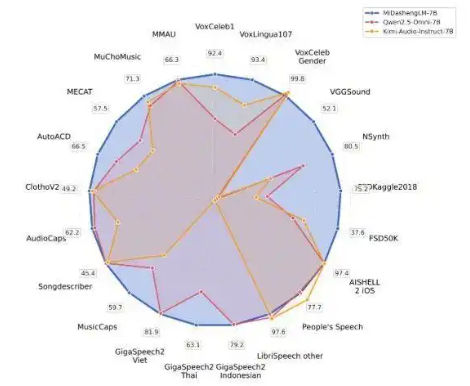

MiDashengLM是小米开源的高效声音理解大模型,模型基于 Xiaomi Dasheng 音频编码器和 Qwen2.5-Omni-7B Thinker 解码器构建,用通用音频描述对齐策略,实现对语音、环境声音和音乐的统一理解。模型性能卓越,推理效率高,首 Token 延迟仅为业界先进模型的 1/4,支持大规模并行处理。模型训练数据完全开源,支持学术和商业用途,适用于智能座舱、智能家居等场景,推动多模态交互体验升级。

MiDashengLM-7B是在小米此前的声音基础模型Xiaomi Dasheng基础上研发的升级版本,结合了先进的语言处理技术(Qwen2.5-Omni-7B模型),可以同时理解语音、人类活动产生的环境声以及音乐内容,具备更强的综合“听懂”能力。将音频内容(包括语音、环境声、音乐等)转化为自然语言描述,帮助用户快速理解音频信息。

MiDashengLM的技术原理

- 模型架构:

- 音频编码器:基于 Xiaomi Dasheng 音频编码器,负责将输入的音频信号转换为高维特征表示。Dasheng 编码器在音频理解任务中表现出色,在处理非语音类音频(如环境声音和音乐)时,能提取丰富的语义信息。

- 解码器:基于 Qwen2.5-Omni-7B Thinker 自回归解码器,负责将音频编码器提取的特征转换为自然语言描述。解码器支持多种任务,包括音频描述、音频问答和语音识别等。

- 训练策略:

- 通用音频描述对齐:基于通用音频描述对齐策略,避免传统 ASR 转录方法的局限性,通过非单调的全局语义映射,迫使模型学习音频场景的深层语义关联,实现对语音、环境声音和音乐的统一理解。

- 多专家分析:训练数据基于多专家分析管道生成,包括语音、人声、音乐和环境声学的细粒度标注,再用 DeepSeek-R1 推理大模型合成统一描述。

- 数据集:用公开数据集进行训练,涵盖语音、环境声音、音乐等多个领域,总时长超过 100 万小时。训练数据的原始标签在预训练中被弃用,只用新的丰富文本描述标签,迫使模型学习更丰富全面的声音信息。

- 推理效率优化:

- 高效推理:通过优化音频编码器设计,将输出帧率从 Qwen2.5-Omni 的 25Hz 降低到 5Hz,显著降低计算负载并提高推理效率。

- 大规模并行处理:支持更大的批量处理(batch size=512),在 80GB GPU 上处理 30 秒音频并生成 100 个 token 时,MiDashengLM 的吞吐量速度是 Qwen2.5-Omni-7B 的 20 倍以上。

MiDashengLM的应用场景

- 智能座舱:基于语音助手和环境声音识别,提升驾驶安全性和交互体验。

- 智能家居:用语音控制和环境声音监测,实现便捷的家居自动化。

- 语音助手:提供多语言语音识别和智能对话,满足用户多样化需求。

- 音频内容创作与标注:自动生成音频描述和标签,提高内容创作效率。

- 教育与学习:为用户辅助语言和音乐学习,提供发音反馈和理论指导。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...