智谱宣布推出新一代开源视觉推理模型GLM-4.5V,并同步在魔搭社区与Hugging Face平台开源。GLM-4.5V基于智谱发布的新一代旗舰文本基座模型GLM-4.5-Air,沿用了GLM-4.1V-Thinking的结构。该模型总参数106B,激活参数12B,官方称其在全球100B级开源视觉模型中效果最佳。GLM-4.5V由视觉编码器、MLP 适配器和语言解码器三部分组成,支持64K多模态长上下文。

GLM-4.5V是什么

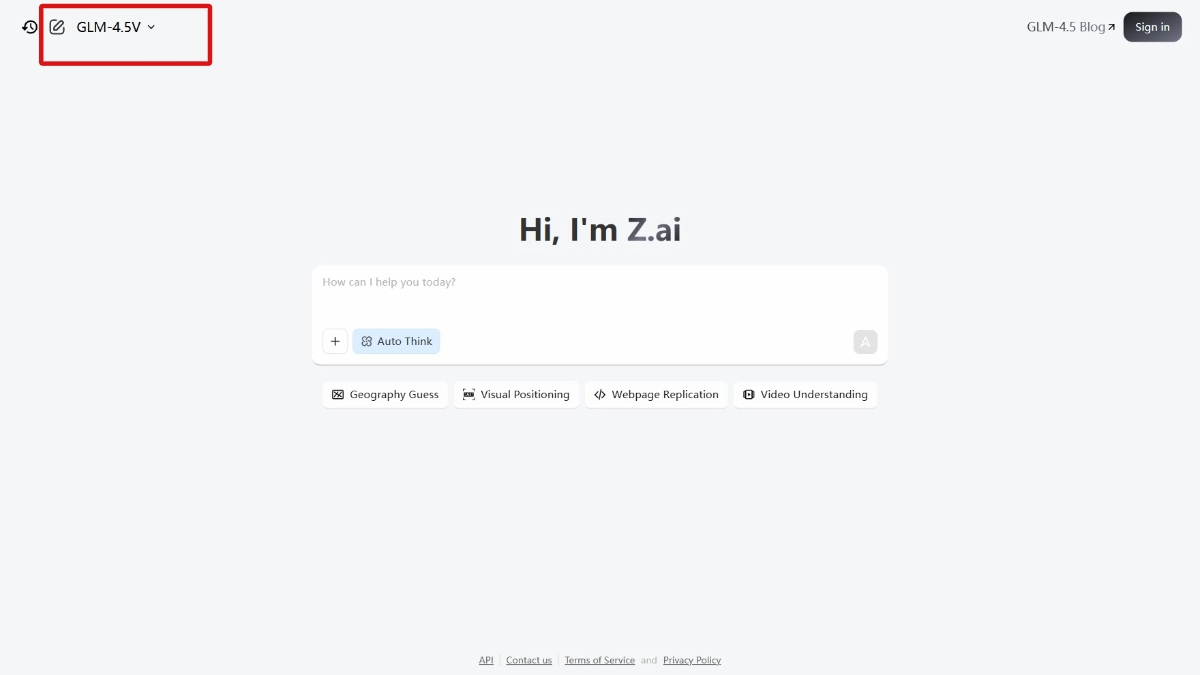

GLM-4.5V是智谱推出的全球领先的开源视觉推理模型,总参数达1060亿,激活参数120亿。模型基于新一代文本基座模型GLM-4.5-Air训练而成,具备强大的视觉理解与推理能力,能处理图像、视频、文档等多种视觉内容。模型在多模态任务中表现出色,涵盖视觉问答、图像描述生成、视频理解、网页前端复刻等场景,同时支持快速响应与深度推理的灵活切换。GLM-4.5V在41个公开视觉多模态榜单中达到SOTA性能,通过高效混合训练实现全场景视觉推理,为企业和开发者提供高性价比的多模态AI解决方案。

GLM-4.5V的功能

- 图像推理:能理解复杂场景中的物体、人物关系和背景信息。

- 视频理解:支持对长视频内容的分析,包括分镜、事件识别和关键信息提取。

- 多模态交互能力:

- 文本与视觉融合:支持根据文本描述生成图像,或者根据图像生成文本描述。

- 跨模态生成:能够将视觉内容转换为文本,或将文本内容转换为视觉内容。

- 网页前端复刻:能根据网页设计图生成前端代码,实现快速网页开发。用户只需上传网页截图或交互视频,模型即可生成完整的HTML、CSS和JavaScript代码。

- 图寻游戏:支持基于图像的搜索和匹配任务。例如,在复杂场景中快速找到特定目标图像,适用于安防监控、智能零售及娱乐游戏开发。

- 复杂文档解读:能够处理长文档和复杂图表,进行信息提取、总结和翻译。支持输出自己的“观点”,不仅仅是简单的信息提取。

GLM-4.5V的核心优势

- 强大的视觉理解与推理能力:能深度理解复杂的视觉内容,包括图像、视频和文档。不仅能识别物体、场景和人物关系,还能进行高级推理,例如通过图像中的细微线索推断背景信息

- 多模态交互与生成能力:支持文本与视觉内容的无缝融合,能根据文本描述生成图像,或者根据图像生成文本描述。模型支持实现跨模态生成,例如将视觉内容转换为文本,或者将文本内容转换为视觉内容。

- 高效的任务适配与推理模式:通过高效的混合训练,具备全场景视觉推理能力,能处理图像推理、视频理解、GUI任务、复杂图表与长文档解析等多种任务。

- 高性价比与快速部署:在保持高精度的同时,兼顾推理速度与部署成本。其API调用价格低至输入2元/M tokens,输出6元/M tokens,响应速度达到60-80 tokens/s。

- 开源与广泛的社区支持:提供GitHub仓库、Hugging Face模型库和魔搭社区等多种渠道,方便开发者快速上手和二次开发,提供桌面助手应用,支持实时截屏、录屏,方便开发者体验模型能力。

- 广泛的应用场景:适用多种实际应用场景,包括网页前端复刻、视觉问答、图寻游戏、视频理解、图像描述生成和复杂文档解读。

GLM-4.5V的适用人群

- 开发者:为开发者提供强大的多模态开发能力,帮助他们快速构建视觉问答、图像生成、视频分析等应用。

- 企业用户:企业用视觉理解能力,优化安防监控、智能零售、视频推荐等业务场景。

- 研究人员:研究人员借助GLM-4.5V的开源模型和数据集,开展多模态推理、视觉语言融合等领域的前沿研究。

- 普通用户:普通用户用图像描述、视频理解等功能,提升内容创作效率和信息获取能力。

- 教育工作者和学生:教育工作者和学生辅助教学和学习,提升教育体验。

本站信息分享,不代表本站观点和立场。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...