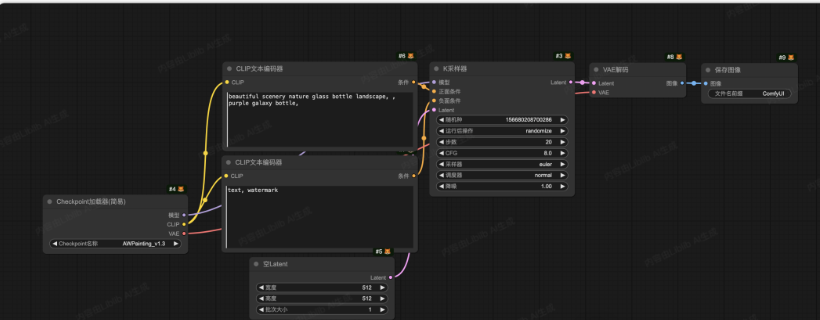

在 ComfyUI 中,一幅图像的生成其实就是一条“流水线”。它从模型加载开始,到提示词输入,再到采样与解码,最后输出为可见图像。整体逻辑可以概括为以下几个步骤:

下面结合工作流图,逐一拆解每个节点的功能。

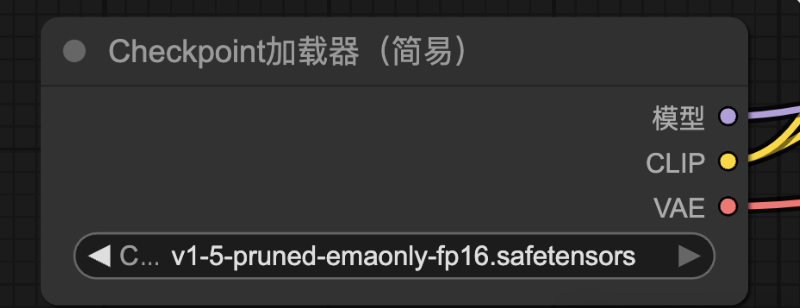

下面结合工作流图,逐一拆解每个节点的功能。1. Checkpoint加载器

用来加载基础大模型,是影响出图结果的核心。基础生成模型(Base Model) 是整个创作“画师”。它决定了画面的清晰度、风格、提示词理解能力。

- 模型(用于采样器)

- CLIP(用于文本编码器)

- VAE(用于图像解码)

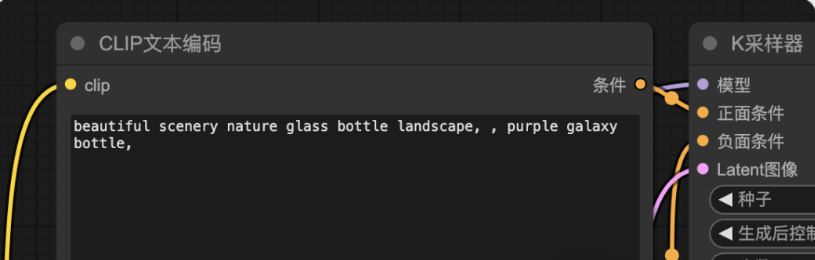

2. CLIP文本编码器(正向提示词)

连接到正面条件的CLIP文本。

把输入的文字提示转化为语义向量,让模型能够“理解”人类的语言,从而指导图像生成。

- 先写质量词(如:高质量、高清、细节丰富)

- 再写主体词(如:一个女孩,双马尾,蓝色头发,校服)

- 在写氛围词(如:教室背景,动漫风格)

这样写,是因为越靠前,词汇的权重越高。对呈现的呈现影响也会越大。

3. CLIP文本编码器(负面提示词)

和正向提示词作用相反,用来“抑制”不想要的特征,例如模糊、混乱、低质量、缺少细节等。

在一些新模型中,负向提示词可能不是必需的,因为模型本身已内置了质量优化。

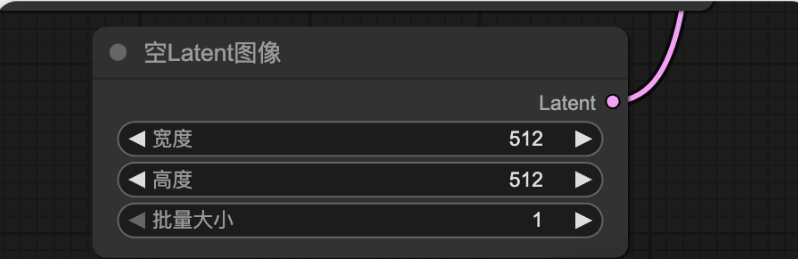

4. 空Latent

生成一个随机的 latent 空间(噪声图),作为整个生成过程的起点。不同的模型对宽高的支持不同,比如SD1.5仅支持最大512 * 512大小的图像。

latent 空间也叫潜空间。他的作用有一点类似文本向量,用来简化计算机的理解,让他更容易生成图像。

- 宽度:图片宽度

- 高度:图片高度

- 批量大小:一次生成几张图片。

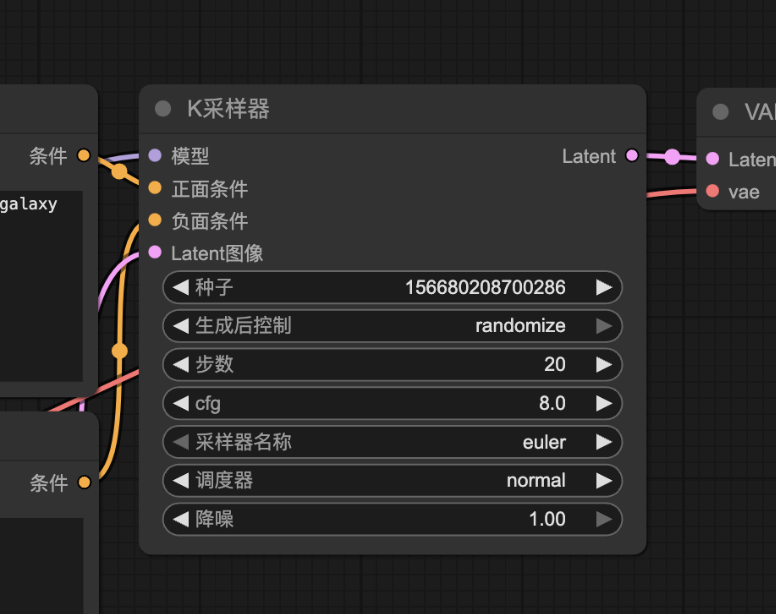

5. K采样器

核心的采样节点,基于扩散模型在 latent 空间里生成图像。

在生成模型(尤其是扩散模型)中,模型训练出来的是一个 噪声到图像的映射函数。

- 采样器就是从噪声生成图像的算法或策略。

- K采样器本质上是一种 迭代算法,通过多次更新噪声向量,将其逐步转换成清晰的图像。

就像雕塑家从一块粗糙的石头开始,逐步敲打,最终得到完整的雕像。

图像生成的过程如下:从一个模糊不清的图像,逐渐变得清晰。

- 模型(来自 Checkpoint)

- 正面条件(Prompt 编码器)

- 负面条件(Negative Prompt 编码器)

- Latent(来自空Latent)

- 随机种子:控制生成图像的随机性。相同的种子 + 相同的条件会生成完全一致的图像。

- 运行后操作:控制图像生成完成后的额外操作,例如是否随机化种子等。

- 步数:控制采样的迭代次数,即去噪过程的步数。

- CFG:控制提示词对结果影响力度

- 采样器:选择具体的去噪迭代算法。

- 调度器:控制去噪随步数变化的强度。

- 噪声:控制 Latent 图像去噪的强度。

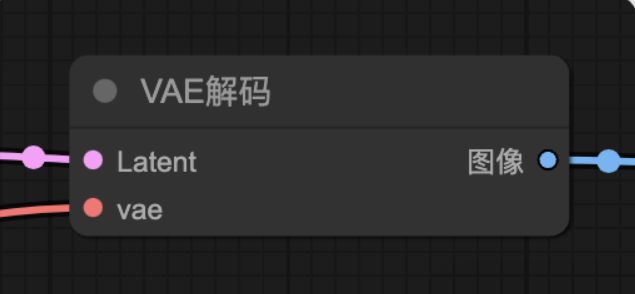

6. VAE解码

功能:将采样器输出的 latent 空间数据解码为可见图像。

- Latent(来自采样器)

- VAE(VAE模型,有的模型内置,也可以从外部引用单独的VAE模型)

输出:真实可见图像。

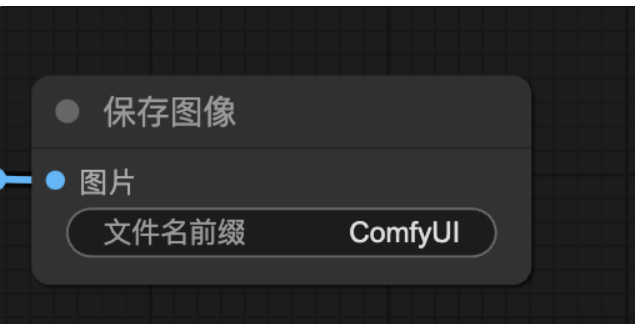

7. 保存图像

- 功能:将生成的图像保存到本地。

总结

以上就是一个文生图的基本工作流。就是用一个模型,基于提示词等等一系列条件,把一个无序的空Latent图像,通过很多步的重复,变成目标图像。

- 先有一个大模型(Checkpoint),

- 通过提示词(CLIP)提供创作方向,

- 在 latent 空间里用采样器不断迭代(逐步去噪),

- 再通过 VAE 解码,

- 最终得到清晰可见的图像。

一句话总结就是,模型是画师,提示词是灵感,采样器是雕刻过程,VAE 是还原工具,最终呈现就是一幅完整的作品。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...