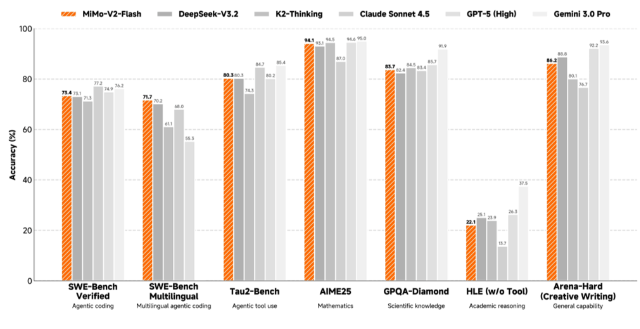

mimo-v2-flash 是小米推出的开源高性能大语言模型,整体参数量达3090亿,其中每轮推理激活参数为150亿。仅用了309B的参数规模,该模型就展现出了极高的效能密度,在多项权威综合评测中均取得了令人瞩目的优异成绩。在保持长文本性能的同时显著降低KV缓存存储量。此外,配备了轻量级多Token预测(MTP)模块,每个模块仅包含0.33亿参数,使用密集前馈网络(FFN)和SWA,能显著提升生成速度,使推理成本仅为标杆闭源模型Claude 4.5 Sonnet的2.5%,生成速度提升2倍。MiMo-V2-Flash 在多个智能体任务和复杂推理任务中表现出色,如SWE-Bench和数学推理任务。支持FP8混合精度推理,推荐使用SGLang框架进行部署。

MiMo-V2-Flash的主要功能

- 高性能推理:采用混合注意力架构和轻量级多Token预测技术,显著提升推理效率,生成速度更快,推理成本大幅降低。

- 长文本处理能力:通过滑动窗口注意力和全局注意力的结合,支持长达256K的上下文长度,适合处理长文本任务。

- 智能体任务优化:经过大规模智能体强化学习和多教师在线策略蒸馏,专为智能体AI设计,适合复杂推理和多轮对话任务。

- 代码生成与理解:在代码生成和理解任务中表现出色,支持多种编程语言,能够高效完成代码补全、生成和调试任务。

- 多语言支持:具备多语言能力,能够处理多种语言的文本生成、翻译和理解任务。

- 开源与易用性:模型权重和推理代码全面开源,采用MIT协议,便于开发者使用和二次开发。

MiMo-V2-Flash的技术原理

- 混合注意力架构:采用滑动窗口注意力(SWA)和全局注意力(GA)混合设计,以128个token为窗口大小,通过可学习的注意力下沉偏置(sink bias)技术,在降低KV缓存存储量的同时,保持长文本处理能力。

- 轻量级多Token预测(MTP):配备轻量级MTP模块,使用密集前馈网络(FFN)和滑动窗口注意力,每个模块仅0.33亿参数,显著提升生成速度,优化推理效率。

- 高效预训练:使用27万亿tokens进行预训练,支持原生32K序列长度,上下文窗口可扩展至256K,采用FP8混合精度训练,提升训练效率。

- 智能体强化学习:通过大规模智能体强化学习和多教师在线策略蒸馏(MOPD),在复杂推理和智能体任务中表现出色,提升模型的泛化能力和任务适应性。

- 推理优化:支持FP8混合精度推理,结合SGLang框架,提供高效的推理性能,适合大规模部署和应用。

MiMo-V2-Flash的应用场景

- 智能体AI任务:适用于需要高效推理和复杂任务处理的智能体场景,如自动化任务执行、多轮对话管理和工具调用。

- 长文本处理:能处理长文本生成和理解任务,如长篇内容创作、文档摘要和长文本问答。

- 代码生成与理解:支持代码生成、代码补全和代码理解,适用于开发者工具集成和自动化编程辅助。

- 多语言应用:具备多语言能力,可用于跨语言翻译、多语言内容生成和国际化应用开发。

- 复杂推理任务:在数学推理、逻辑推理和科学问题解答等复杂任务中表现出色,适合教育和研究领域。

- 日常助手:作为通用AI助手,可用于日常问答、信息检索和个性化内容推荐。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...